在当今这个由微服务和分布式系统主导的时代,如何确保服务之间高效、可靠的通信,同时维持系统的松耦合与高可扩展性,已成为每一位全栈开发者都必须面对的核心挑战。传统的紧耦合、同步调用模式在复杂系统面前显得捉襟见肘,而事件驱动架构 (EDA) 则作为一种优雅的解决方案应运而生。它不仅改变了我们构建应用程序的方式,也催生了强大的技术工具。在这场架构革命的中心,消息队列扮演着无可替代的“交通枢纽”角色。

而在众多消息队列和事件流平台中,RabbitMQ 和 Apache Kafka 无疑是两座无法逾越的高峰。它们都承诺解决异步通信的难题,但其底层的设计哲学、核心机制和适用场景却大相径庭。对于开发者而言,选择错误的工具可能会给项目带来长期的技术债务和性能瓶颈。因此,这不仅仅是一个技术选型问题,更是一个关乎系统架构未来的战略决策。

本文将以一名全栈开发者的视角,深入剖析 RabbitMQ 和 Kafka 的本质区别。我们将不仅仅停留在功能列表的比较,而是会深入探讨它们的设计理念、架构模型、性能特点,并结合实际的业务场景,如支付系统、事件溯源等,为您提供一个清晰、务实的决策框架。无论您是正在为新项目进行技术选型,还是希望优化现有系统的消息传递机制,相信本文都能为您带来深刻的洞见和实用的指导。

什么是事件驱动架构 (EDA)?

在我们深入比较 RabbitMQ 和 Kafka 之前,首先必须理解它们所服务的核心架构范式——事件驱动架构 (Event-Driven Architecture, EDA)。简单来说,EDA 是一种软件架构模式,其中系统的各个组件通过生产和消费异步传递的“事件”来进行通信和协作。一个“事件”代表了系统中发生的一个有意义的状态变化,例如“用户已下单”、“支付已成功”或“库存已更新”。

在这种模式下,服务之间不再直接调用彼此的 API,而是将发生的事件发布到一个中心化的事件路由器(即消息代理或事件流平台)。其他对此类事件感兴趣的服务则可以订阅并接收这些事件,然后执行相应的业务逻辑。这种方式极大地降低了服务之间的耦合度。

- 事件生产者 (Event Producer): 负责创建并发布事件的组件。它只关心事件的发布,不关心谁会消费这个事件。

- 事件路由器/代理 (Event Router/Broker): 接收来自生产者的事件,并根据预设的规则将其路由到一个或多个消费者。这是 消息队列 系统的核心职责。

- 事件消费者 (Event Consumer): 订阅并处理事件的组件。消费者可以根据自身业务需求对事件做出响应,甚至在处理后产生新的事件。

想象一个新闻发布会。发言人(生产者)发布一条新闻(事件),他不需要知道台下有哪些记者(消费者),也不需要逐个通知他们。记者们可以根据自己的兴趣领域(订阅)来决定是否记录这条新闻。而中间的媒介,如扩音系统和直播平台(事件路由器),则确保了消息能够被所有感兴趣的人接收到。

事件驱动架构 带来的好处是显而易见的:

- 高度解耦 (Loose Coupling): 生产者和消费者相互独立,可以独立开发、部署、扩展和修改,而不会影响到对方。

- 卓越的可扩展性 (Scalability): 我们可以轻松地增加更多的消费者实例来并行处理事件,从而提高整个系统的吞吐量。同样,也可以增加新的服务类型来订阅现有事件,轻松扩展业务功能。

- 增强的韧性与容错性 (Resilience & Fault Tolerance): 如果一个消费者服务暂时不可用,事件会安全地存储在消息代理中,待服务恢复后再进行处理,避免了数据丢失。

- 实时响应能力 (Real-time Responsiveness): 事件在发生时即可被推送和处理,非常适合需要实时数据处理和响应的场景。

理解了 EDA 的这些优势,我们就能更好地理解为什么像 RabbitMQ 和 Kafka 这样的技术在现代软件开发中占据了如此重要的地位。它们正是实现这一切优势的关键基础设施。

为什么现代应用需要消息队列?

这直接回答了“为什么应该使用消息队列”这个核心问题。在复杂的分布式系统中,服务间的直接同步调用(如 REST API 或 gRPC)虽然简单直接,但会带来一系列问题:性能瓶颈、级联故障和紧耦合。消息队列 作为服务间通信的中间层,有效地解决了这些痛点,其价值主要体现在以下几个方面:

1. 异步通信 (Asynchronous Communication)

这是消息队列最核心、最直接的价值。在同步通信模式下,服务 A 调用服务 B,必须等待服务 B 处理完成并返回结果后才能继续执行。如果服务 B 响应缓慢,服务 A 就会被阻塞。

场景示例:用户注册

在一个同步系统中,用户提交注册信息后,服务器需要依次完成:1. 写入用户数据库;2. 发送欢迎邮件;3. 初始化用户积分。整个过程可能耗时数秒,用户必须在页面上等待。

引入消息队列后,流程变为异步:

- 服务器接收到注册请求后,仅执行最核心的“写入用户数据库”操作。

- 然后,它向消息队列发送一个“UserRegistered”事件。

- 服务器立即向用户返回“注册成功”的响应,用户体验极佳。

- 后台的“邮件服务”和“积分服务”分别消费“UserRegistered”事件,并异步地执行发送邮件和初始化积分的操作。

这种模式下,核心流程的响应时间被大大缩短,系统的吞吐能力和用户体验都得到了显著提升。

2. 系统解耦 (Decoupling)

消息队列作为中间人,使得生产者和消费者之间无需直接感知对方的存在。生产者只需将消息发送到指定的队列或主题,而消费者只需从该队列或主题中获取消息。它们之间的唯一契约就是消息的格式。

这种解耦带来了巨大的灵活性:

- 独立演化: 我们可以随时升级或替换邮件服务,只要它还能正确处理“UserRegistered”事件,注册服务就完全不受影响。

- 轻松扩展: 如果我们想在用户注册后增加一个新的业务逻辑,比如“发送新用户优惠券”,我们只需要开发一个新的“优惠券服务”来消费“UserRegistered”事件即可,无需对现有的任何服务进行任何代码修改。

3. 流量削峰与缓冲 (Traffic Shaping & Buffering)

在电商秒杀、双十一大促等场景下,系统会在短时间内接收到远超其常规处理能力的请求洪峰。如果这些请求直接冲击后端的数据库或核心服务,很可能导致整个系统崩溃。

消息队列在这里扮演了一个巨大的缓冲区的角色。它能够接收所有瞬时涌入的请求(消息),并将它们暂存起来。后端的消费者服务则可以按照自己稳定的处理能力,匀速地从队列中拉取消息进行处理。这就像一个水库,在洪水来临时蓄水,然后平稳地向下游放水,从而保护了下游系统的安全稳定。

4. 增强的可靠性与最终一致性 (Enhanced Reliability & Eventual Consistency)

消息队列通常都具备持久化机制。当生产者发送消息后,消息会被持久化到磁盘上,直到被消费者成功处理并确认。即使在消息被处理之前消费者服务宕机,消息也不会丢失。当服务恢复后,它能继续从上次中断的地方开始处理,确保了业务操作的最终完成。

这使得我们能够轻松实现“最终一致性”模型。即使在分布式系统中,各个服务状态的更新不是同时完成的,但通过可靠的消息传递,我们能保证在一定时间后,所有相关服务都将达到一致的状态。

RabbitMQ 深度解析:传统消息代理的王者

RabbitMQ 是一款成熟、稳定且功能丰富的开源消息代理(Message Broker),是消息队列领域事实上的标准之一。它由 Erlang 语言开发,这赋予了它在并发处理和可靠性方面的天然优势。RabbitMQ 最核心的特点是它完整实现了 AMQP (Advanced Message Queuing Protocol) 0-9-1 协议,这是一个为金融等关键业务领域设计的、功能非常全面的消息传递协议。

理解 RabbitMQ 的关键在于理解其核心的 AMQP 模型,这个模型非常灵活,但也相对复杂。

RabbitMQ 的核心概念

RabbitMQ 的消息流转路径比 Kafka 要精细得多,它引入了 Exchange(交换机)这一核心概念,实现了生产者与队列的解耦。

- Producer (生产者): 创建消息并将其发布到 Exchange。

- Consumer (消费者): 连接到 Queue 并从中消费消息。

- Connection & Channel: 客户端与 RabbitMQ 服务器之间的 TCP 连接。一个连接内可以创建多个 Channel(信道),大多数操作(如发布消息、订阅队列)都在 Channel 上进行,这是一种轻量级的复用机制。

- Queue (队列): 存储消息的缓冲区。它是消息的终点,等待消费者来获取。

- Exchange (交换机): 接收来自生产者的消息,并根据其类型和路由规则(Routing Key)将消息路由到一个或多个绑定的 Queue 中。这是 RabbitMQ 路由能力的核心。

- Binding (绑定): 连接 Exchange 和 Queue 的桥梁。它定义了 Exchange 应如何将消息路由到特定的 Queue。

- Routing Key (路由键): 生产者在发送消息给 Exchange 时附带的一个字符串。Exchange 会用它来决定消息的去向。

强大的 Exchange 类型

RabbitMQ 的强大之处很大程度上体现在其多样化的 Exchange 类型上,这使得开发者可以实现非常复杂的路由逻辑。

| Exchange 类型 | 工作方式 | 核心用途 | 场景举例 |

|---|---|---|---|

| Direct | 将消息路由到 Binding Key 与消息的 Routing Key 完全匹配的 Queue。 | 点对点通信,任务队列。 | 将特定类型的任务(如 `image.resize`)发送给专门处理该任务的工作队列。 |

| Fanout | 将接收到的所有消息广播到所有绑定到该 Exchange 的 Queue,忽略 Routing Key。 | 发布/订阅模式,广播通知。 | 系统配置发生变更,需要通知所有相关服务立即刷新缓存。 |

| Topic | 根据 Routing Key 和 Binding Key 之间的模式匹配(通配符 `*` 和 `#`)来路由消息。`*` 匹配一个单词,`#` 匹配零个或多个单词。 | 灵活的多播,根据消息内容进行分类路由。 | 日志系统。Routing Key可以是 `log.error.auth`,一个消费者可以订阅 `log.error.*` 来接收所有错误日志,另一个消费者可以订阅 `log.#` 来接收所有日志。 |

| Headers | 不依赖 Routing Key,而是根据消息头(Headers)中的键值对来进行匹配。性能稍差,不常用。 | 在非字符串路由键上进行路由。 | 根据消息头中 `format=pdf` 且 `type=report` 的条件来路由消息。 |

RabbitMQ 的优势 (Pros)

- 灵活的路由: 多种 Exchange 类型和强大的绑定规则提供了无与伦比的路由灵活性,能够满足各种复杂的消息分发需求。

- 成熟稳定: 作为一个老牌项目,RabbitMQ 经过了长时间的生产环境考验,拥有庞大的社区、丰富的客户端库和详尽的文档。

- 完善的管理界面: 内置的 Web 管理插件非常强大,可以方便地监控和管理 Exchanges、Queues、Connections、Channels、用户和权限等。

- 协议支持广泛: 除了核心的 AMQP,还通过插件支持 MQTT、STOMP 等协议,方便物联网等场景的接入。

- 精细的消息控制: 支持消息确认(Acknowledgements)、持久化、TTL(Time-To-Live)、死信队列(Dead-Letter-Exchange)等高级特性,能对消息的生命周期进行精细控制。

RabbitMQ 的劣势 (Cons)

- 吞吐量瓶颈: 相较于 Kafka,RabbitMQ 在处理海量消息(如每秒数十万条以上)时,吞吐量较低。它的设计目标是可靠地传递消息,而非极限吞吐。

- 消息堆积性能下降: 当队列中堆积大量消息时,其性能会显著下降。它更适合作为“管道”而非“数据库”。

- 集群扩展相对复杂: 虽然支持集群,但其元数据同步和高可用配置比 Kafka 更为复杂。

- 消息追溯困难: 消息被消费并确认后,通常会被删除。这使得“重放”或“回溯”历史消息变得困难或不可能。

适用场景

- 任务队列/后台作业: 例如,处理用户上传的视频转码、生成报表、发送邮件等耗时操作。

- 服务间通信 (RPC/Command): 在微服务架构中,用于服务间的命令传递和异步 RPC 调用。

- 金融系统: 对消息的顺序、事务性和可靠性要求极高的场景。

- 即时通知: 需要将消息可靠地推送给特定用户的场景。

总而言之,RabbitMQ 是一个“聪明的”消息代理。它承担了复杂的消息路由和管理工作,让生产者和消费者可以变得“简单”。

Apache Kafka 深度解析:分布式流处理平台

Apache Kafka 与 RabbitMQ 的定位有着本质的不同。它不仅仅是一个消息队列,而是一个为处理实时数据流而设计的分布式事件流平台 (Distributed Event Streaming Platform)。它最初由 LinkedIn 开发,用于处理网站活动日志,其核心设计目标就是:高吞吐、高可用和水平扩展。

理解 Kafka 的关键,是把它看作一个分布式的、分区的、可复制的、持久化的提交日志 (Commit Log)。这是一个与传统消息队列完全不同的概念。

Kafka 的核心概念

Kafka 的架构模型更为简洁,但其分布式特性引入了一些新的概念。

- Producer (生产者): 创建事件(在 Kafka 中称为 Record 或 Message)并将其发布到 Kafka 的 Topic。

- Consumer (消费者): 从 Topic 订阅并消费事件。消费者通常以消费者组 (Consumer Group) 的形式存在。

- Broker (代理): 一个 Kafka 服务器实例。多个 Broker 组成一个 Kafka 集群。

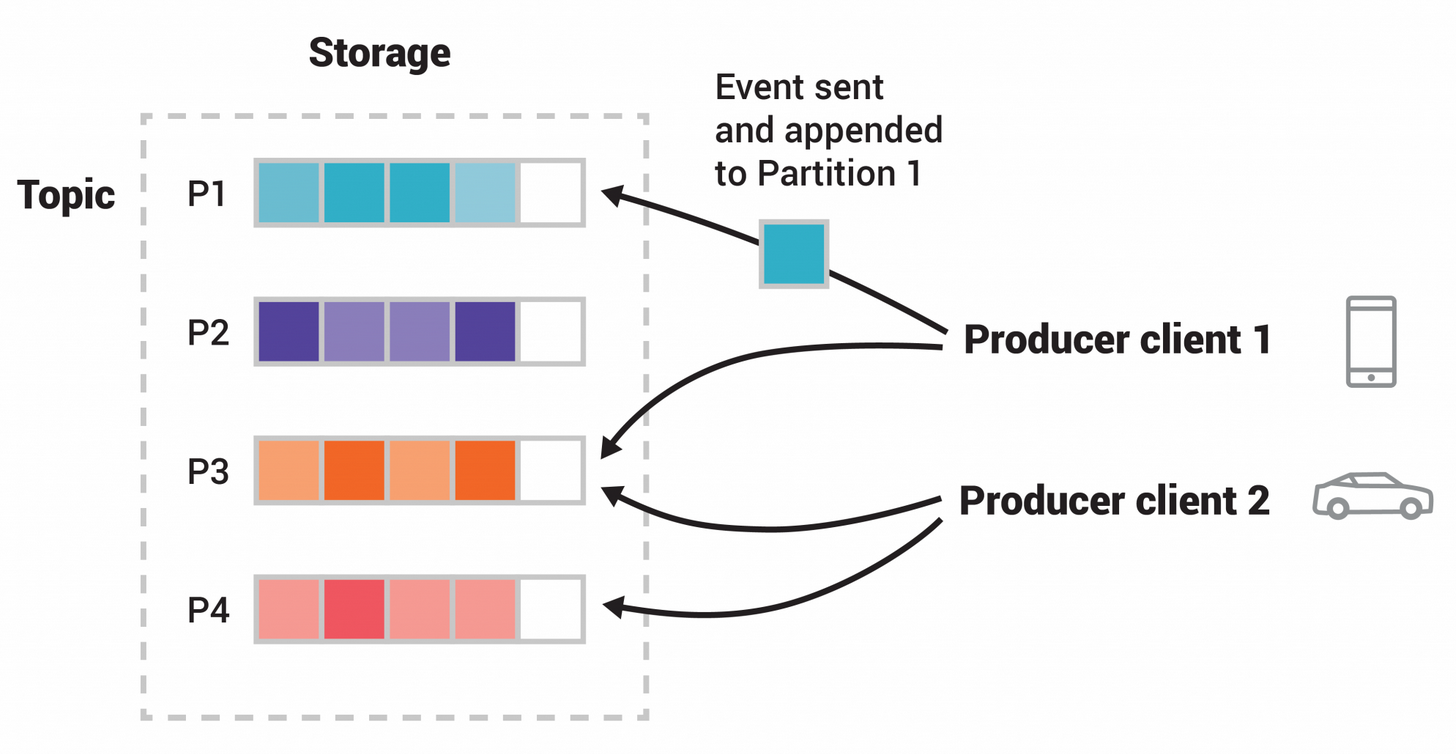

- Topic (主题): 事件的逻辑分类。类似于数据库中的表。生产者将事件发布到特定 Topic,消费者从特定 Topic 订阅事件。

- Partition (分区): Topic 的物理分组。每个 Topic 可以被划分为一个或多个 Partition。Partition 是 Kafka 实现并行处理和水平扩展的基础。在一个 Partition 内,消息是严格有序的。

- Offset (偏移量): Partition 中每条消息的唯一标识符,是一个单调递增的整数。消费者通过 Offset 来追踪自己消费到了哪个位置。

- Consumer Group (消费者组): 一个或多个消费者组成的逻辑单元。发布到 Topic 的每条消息只会被同一个 Consumer Group 内的一个消费者实例消费。这使得我们可以通过增加消费者实例来横向扩展处理能力。

- Replication (复制): 每个 Partition 都可以有多个副本(Replica),分布在不同的 Broker 上,以实现高可用。其中一个副本为 Leader,负责读写;其他为 Follower,负责同步数据。

Kafka 的独特机制

- 持久化的日志结构: Kafka 将所有消息持久化到磁盘上,并且可以配置保留策略(如保留 7 天或直到磁盘空间达到阈值)。消息被消费后不会立即删除。这使得 Kafka 不仅是消息管道,更像是一个短期的事件数据库。

- 消息重放 (Message Replay): 由于消息被持久化,消费者可以重置自己的 Offset 到任意位置,从而“重放”或重新处理历史数据。这对于错误修复、数据分析和新功能上线非常有用。

- 消费者拉取模型 (Pull Model): 与 RabbitMQ 的推送模型不同,Kafka 的消费者主动从 Broker 拉取数据。这使得消费者可以根据自己的处理能力来控制消费速率,避免了被 Broker 推送过多消息而压垮。

- 无与伦比的性能: Kafka 通过顺序读写磁盘、零拷贝(Zero-copy)等技术优化,实现了惊人的吞吐量,能够轻松处理每秒百万级别的消息。

Kafka 的优势 (Pros)

- 极高的吞吐量: 为大数据和流处理而生,是目前业界公认的吞吐量最高的事件系统之一。

- 天生的可扩展性: 通过分区机制,可以轻松地对 Topic 和消费者进行水平扩展,以应对不断增长的数据量。

- 高可用与容错: 分区副本机制确保了即使部分 Broker 宕机,数据也不会丢失,服务也能继续。

- 持久化与消息重放: 强大的消息保留和重放能力,使其成为事件溯源、流处理和数据湖集成的理想选择。

- 丰富的生态系统: 拥有 Kafka Connect (用于连接外部系统)、Kafka Streams (用于构建流处理应用)、ksqlDB (事件流数据库) 等强大的生态组件,构成了一个完整的平台。

Kafka 的劣势 (Cons)

- 学习曲线较陡: 分区、Offset、消费者组、副本同步、Zookeeper/KRaft 依赖等概念比 RabbitMQ 更复杂,运维和调优需要更多的专业知识。

- 路由能力有限: Kafka 的路由逻辑非常简单,生产者直接将消息发送到指定 Topic 的指定 Partition(或由其自动选择)。它没有像 RabbitMQ Exchange 那样复杂的条件路由能力。 * 消息延迟相对较高: 为了追求吞吐量,Kafka 通常采用批量处理的方式,这可能导致单条消息的端到端延迟略高于 RabbitMQ。

- 不支持复杂的消息协议: Kafka 使用自定义的二进制 TCP 协议,不像 RabbitMQ 那样原生支持 AMQP、MQTT 等多种标准协议。

适用场景

- 日志聚合与分析: 收集来自不同服务的应用日志、监控指标,进行集中处理和分析。

- 实时数据流处理: 结合 Kafka Streams 或 Flink/Spark Streaming,进行实时欺诈检测、推荐系统、ETL 等。

- 事件溯源 (Event Sourcing): 将应用状态的每一次变更都作为事件记录在 Kafka Topic 中,作为系统唯一的、可信的数据源。

- 数据同步/CDC (Change Data Capture): 捕获数据库的变更事件,并将其发布到 Kafka,以同步到其他数据存储或分析系统中。

与 RabbitMQ 相反,Kafka 是一个“愚笨的”代理,但拥有“聪明的”消费者。Broker 的职责很简单:高效、可靠地存储和提供数据流。而所有复杂的逻辑,如消费到哪里、如何处理数据,都由消费者自己负责。

RabbitMQ vs. Kafka:核心差异的正面交锋

现在,我们已经分别深入了解了 RabbitMQ 和 Kafka,是时候将它们放在一起进行一次全面的对比了。这不仅仅是功能的罗列,更是设计哲学的碰撞。这部分内容将直接解答“RabbitMQ和Kafka的区别”。

- RabbitMQ: 智能代理/愚笨消费者 (Smart Broker / Dumb Consumer)。代理(Broker)负责消息的路由、过滤和分发。消费者只需被动地从指定的队列接收消息即可。 - Kafka: 愚笨代理/智能消费者 (Dumb Broker / Smart Consumer)。代理(Broker)只负责存储和提供日志数据。消费者需要自己管理消费状态(Offset),并决定从哪个分区拉取数据。

这个核心差异导致了它们在架构、功能和性能上的诸多不同。

| 特性 | RabbitMQ | Apache Kafka |

|---|---|---|

| 架构模型 | 传统的发布/订阅、点对点队列模型 | 分布式、分区的提交日志(Commit Log)模型 |

| 消息消费模型 | 推送 (Push): Broker 主动将消息推送给消费者。 | 拉取 (Pull): 消费者主动从 Broker 拉取消息。 |

| 消息保留/持久化 | 消息在被消费者确认后通常会被删除。主要作为临时管道。 | 消息按策略(时间/大小)长期持久化。可作为短期数据存储。 |

| 吞吐量 | 中等到高(通常每秒数万到十万级别) | 非常高(通常每秒数十万到百万级别) |

| 消息路由 | 极其灵活。通过 Exchange (Direct, Fanout, Topic, Headers) 实现复杂的路由逻辑。 | 简单。生产者将消息发送到指定 Topic 的 Partition。路由逻辑需在生产者或消费者端实现。 |

| 可扩展性 | 支持集群,但通常通过增加消费者或 federation 来扩展。水平扩展相对复杂。 | 原生为水平扩展设计。通过增加 Broker 和 Topic 的 Partition 数量来线性扩展。 |

| 消息重放 | 困难或不可能(除非使用特定插件或复杂设置)。 | 核心功能。消费者可以重置 Offset 到任意位置来重放历史消息。 |

| 消费者状态管理 | 状态主要由 Broker 管理(如哪些消息已被投递和确认)。 | 状态主要由消费者(或 Broker 协调)管理(即 Consumer Group 的 Offset)。 |

| 多租户与协议 | 通过 vhost 实现强大的多租户隔离。支持 AMQP, MQTT, STOMP 等多种协议。 | 通过 ACL 实现权限控制,多租户隔离较弱。使用自定义 TCP 协议。 |

| 主要用途 | 任务队列、后台作业、服务间命令传递、传统企业级消息中间件。 | 实时数据管道、日志聚合、事件溯源、流处理平台。 |

如何选择:一个务实的决策框架

在了解了它们的深入差异后,我们现在可以构建一个“消息代理选择指南”。记住,不存在“最好”的工具,只有“最合适”的工具。选择应基于您的具体业务需求、数据量、团队技术栈和未来发展方向。

何时应该选择 RabbitMQ?

如果你的系统符合以下一个或多个特征,RabbitMQ 可能是更优的选择:

- 需要复杂的路由逻辑: 你的业务需要根据消息内容、类型或属性将消息发送到不同的处理单元。例如,一个订单系统需要根据订单类型(普通、加急、国际)将其分发到不同的处理队列。RabbitMQ 的 Topic 和 Direct Exchange 在这种场景下无与伦比。

- 对单条消息的低延迟要求高: 你的应用场景是处理后台任务或 RPC 调用,需要尽快地将任务分发给空闲的工作进程。RabbitMQ 的 push 模型和内存优化使其在低延迟场景下表现优异。

- 需要精细的消息控制和事务性: 你的业务(如金融交易)要求严格的“至多一次”或“至少一次”投递保证,并且可能需要事务性支持。RabbitMQ 提供了完善的确认机制和事务支持。

- 现有系统或协议集成: 如果你需要与已有的、使用 AMQP、MQTT 或 STOMP 协议的系统进行集成,RabbitMQ 是自然的选择。

- 团队对传统消息队列更熟悉: 如果你的团队对 JMS 或 AMQP 等传统消息模型有深入理解,上手 RabbitMQ 会更加平滑。

何时应该选择 Apache Kafka?

如果你的系统场景与以下描述相符,那么 Kafka 几乎是必然之选:

- 处理海量数据流: 你的核心业务是处理日志、物联网设备数据、用户点击流等每秒产生大量数据的场景。Kafka 的高吞吐量是为这种规模而设计的。

- 需要数据重放或历史数据分析: 你不仅需要处理实时数据,还需要在未来能够重新分析或处理历史事件。例如,当上线一个新的数据分析模型时,你需要用过去几个月的数据来训练它。Kafka 的持久化日志特性是实现这一点的关键。

- 构建事件溯源 (Event Sourcing) 或 CQRS 系统: 你的系统架构基于事件溯源模式,需要一个不可变的、有序的事件日志作为系统的单一事实来源 (Single Source of Truth)。Kafka 就是为此而生的。

- 作为数据湖或数据仓库的入口: Kafka 通常作为大型企业数据架构的核心,充当所有实时数据的汇集点,然后将这些数据流式传输到 Hadoop、Spark、Elasticsearch 或其他数据仓库中。

- 构建复杂的流处理应用: 你需要在数据流上进行实时转换、聚合、窗口计算等操作。Kafka Streams 和 ksqlDB 提供了强大的原生流处理能力。

它们可以共存吗?

是的,完全可以,并且在大型复杂系统中很常见。

一个常见的模式是:使用 Kafka 作为整个系统的“事件骨干网 (Event Backbone)”,负责捕获和传输所有高容量的原始事件流(如用户行为日志、数据库变更日志)。然后,特定的微服务可以消费 Kafka 中的事件,在进行初步处理后,再通过 RabbitMQ 将具体的、需要复杂路由的“命令”或“任务”发送给下游服务进行精细化处理。这种混合架构可以兼具两者的优点。

进阶话题:事件溯源 (Event Sourcing) 与 CQRS

当我们讨论 Kafka 时,不可避免地会触及到事件溯源 (Event Sourcing) 和 CQRS (Command Query Responsibility Segregation) 这两种高级架构模式,因为 Kafka 是实现它们的理想工具。

什么是事件溯源 (Event Sourcing)?

传统的应用数据存储方式是直接保存对象的最终状态。例如,一个银行账户对象在数据库中只保存当前的余额。如果想知道余额是如何变化的,通常需要查询另一张交易流水表。

事件溯源则彻底改变了这种方式。它不保存对象的当前状态,而是将导致对象状态改变的每一个“事件”按顺序存储起来。账户的当前状态是通过从头到尾重放所有相关事件计算出来的。

Martin Fowler "我们捕获系统中发生的所有状态变更,并将其存储为一系列事件。"

例如,一个账户的事件流可能是:`AccountCreated { initialBalance: 0 }` -> `MoneyDeposited { amount: 100 }` -> `MoneyWithdrawn { amount: 20 }` -> `MoneyDeposited { amount: 50 }`。通过重放这些事件,我们可以随时计算出当前余额是 130。

Kafka 与事件溯源的完美结合: Kafka 的 Topic 是一个不可变的、有序的、持久化的日志,这与事件存储 (Event Store) 的要求完全吻合。我们可以为每一种聚合根(如 `Account`)创建一个 Topic,每个 Partition 对应一个具体的实例(如 `account-123`),并将所有针对该实例的事件按顺序写入这个 Partition。Kafka 的持久性和重放能力确保了事件数据的安全和可追溯性。

什么是 CQRS?

CQRS 的核心思想是将系统的“写操作”(命令,Command)和“读操作”(查询,Query)分离。这意味着我们将使用不同的数据模型来处理更新和查询。

- 写模型 (Write Model / Command Side): 负责处理业务逻辑和状态变更。它通常与事件溯源结合,接收命令,验证后产生事件并存储。

- 读模型 (Read Model / Query Side): 负责提供为特定查询优化的数据视图。它通过订阅写模型产生的事件来异步更新自己。读模型可以是关系型数据库、文档数据库、搜索引擎等任何适合查询的存储。

EDA 如何驱动 CQRS: 事件驱动架构是连接 CQRS 写模型和读模型的桥梁。当写模型产生一个事件(如 `OrderConfirmed`)后,它会被发布到消息队列(如 Kafka 或 RabbitMQ)。然后,多个不同的事件处理器(Event Handler)可以订阅这个事件,来更新各自的读模型。例如,一个处理器更新“订单列表”查询视图,另一个处理器更新“销售统计”查询视图。

这种分离带来了巨大的好处:写模型可以专注于业务逻辑的正确性,而读模型可以为各种复杂的查询场景进行高度优化,两者互不干扰,可以独立扩展。

实战案例:将事件驱动架构应用于支付系统

理论的价值最终体现在实践中。让我们通过一个具体的例子——支付系统,来看一下如何应用事件驱动架构,以及 RabbitMQ 和 Kafka 在其中可能扮演的角色。这个案例将展示“将事件驱动架构应用于支付系统”的实际过程。

传统的同步调用方式

在一个简单的单体或紧耦合微服务系统中,支付流程可能是这样的:

function processPayment(request) {

// 1. 验证订单信息

const order = OrderService.validateOrder(request.orderId);

if (!order) { throw new Error("订单无效"); }

// 2. 调用第三方支付网关 (阻塞等待)

const paymentResult = PaymentGateway.charge(order.amount, request.cardInfo);

if (paymentResult.isSuccess) {

// 3. 更新订单状态到 "已支付"

OrderService.updateStatus(request.orderId, "PAID");

// 4. 减少库存

InventoryService.decreaseStock(order.items);

// 5. 发送支付成功邮件 (阻塞等待)

EmailService.sendPaymentSuccessEmail(order.userEmail);

// 6. 返回成功响应给用户

return { success: true, message: "支付成功" };

} else {

// 7. 返回失败响应

return { success: false, message: "支付失败" };

}

}

这种方式的问题:

- 糟糕的用户体验: 用户必须在前端等待所有后台操作完成,整个过程可能耗时很久。

- 低吞吐量: 系统处理一个请求时,大部分时间都在等待 I/O(支付网关、邮件服务)。

- 脆弱性: 如果邮件服务超时或库存服务失败,整个支付流程都可能失败回滚,或者导致数据不一致。

- 紧耦合: 支付流程代码与订单、库存、邮件等服务紧密耦合,任何一个服务的变更都可能影响支付流程。

采用事件驱动架构的重构

现在,我们使用 EDA 和消息队列来重构这个流程。在这里,我们可以使用 Kafka 作为核心的事件总线,因为它能可靠地记录下每一个状态变更,方便审计和后续分析。

第一步: 发起支付,发布事件

API 网关接收到支付请求后,只做最基本的数据校验,然后立即发布一个 `PaymentInitiated` 事件到 Kafka 的 `payment-events` 主题,并马上向用户返回“支付处理中”的响应。

事件内容 (JSON):

{

"eventId": "uuid-1234-abcd-5678",

"eventType": "PaymentInitiated",

"timestamp": "2025-11-17T11:00:00Z",

"payload": {

"orderId": "ORD-98765",

"userId": "USR-123",

"amount": 199.99,

"currency": "USD",

"paymentMethod": "credit_card"

}

}

第二步: 支付处理器消费事件

一个专门的“支付处理服务”消费 `PaymentInitiated` 事件。它负责与第三方支付网关进行交互。这个过程可能是异步的。

处理完成后,无论成功还是失败,它都会发布一个新的事件,如 `PaymentSucceeded` 或 `PaymentFailed`。

事件内容 (JSON):

{

"eventId": "uuid-5678-efgh-9012",

"eventType": "PaymentSucceeded",

"timestamp": "2025-11-17T11:00:05Z",

"correlationId": "uuid-1234-abcd-5678", // 关联原始事件

"payload": {

"orderId": "ORD-98765",

"transactionId": "txn_abcdef123456",

"paidAt": "2025-11-17T11:00:04Z"

}

}

第三步: 各个下游服务响应结果事件

现在,多个对支付结果感兴趣的下游服务可以独立地消费 `PaymentSucceeded` 事件:

- 订单服务: 消费事件,将订单状态更新为 "PAID"。

- 库存服务: 消费事件,执行库存扣减操作。

- 通知服务: 消费事件,向用户发送支付成功的邮件或短信。

- 财务服务: 消费事件,记录入账信息。

- 数据分析服务: 消费事件,更新实时销售仪表盘。

EDA 带来的优势:

- 极佳的用户体验: 用户几乎可以瞬间得到响应。

- 高可用与解耦: 即使通知服务宕机,也不会影响订单和库存的处理。新的服务(如数据分析)可以随时加入,无需修改任何现有代码。

- 可追溯与可审计: Kafka 中记录了完整的事件流,任何时候都可以追溯一笔支付的全过程。

- 高扩展性: 如果订单更新缓慢,我们可以简单地增加“订单服务”的消费者实例数量来并行处理。

总结与展望

通过本文的深度剖析,我们清晰地看到,RabbitMQ 和 Apache Kafka 并非简单的竞争关系,而是针对不同问题域的两种卓越解决方案。RabbitMQ 是一位经验丰富的邮差,擅长于根据复杂的规则精准地投递每一封信件;而 Kafka 则是一条宽阔的数字运河,以无与伦比的容量和速度承载着信息时代的洪流。

作为全栈开发者,我们的任务是深刻理解业务的本质需求,然后选择最合适的工具来构建健壮、可扩展的系统。是需要 RabbitMQ 的灵活路由和精细控制,还是需要 Kafka 的海量吞吐和数据回溯能力?这个问题的答案,蕴藏在你正在构建的系统的每一个细节之中。

随着 Serverless 架构和云原生技术的发展,事件驱动的思想正变得越来越主流。像 AWS EventBridge、Google Cloud Pub/Sub 等托管服务进一步降低了使用 EDA 的门槛。但无论上层技术如何演变,其底层对异步、解耦和数据流的核心需求不会改变。掌握 RabbitMQ 和 Kafka 这两大基石,无疑将为你的架构设计能力和职业发展道路增添至关重要的砝码。不断学习,不断实践,方能在这场数据驱动的浪潮中游刃有余。

Post a Comment