深夜2時、あなたの携帯がけたたましく鳴る。「CPU使用率95%超過」という自動化されたアラート。あなたはベッドから飛び起き、ラップトップを開き、慣れた手順でサーバーにSSH接続し、プロセスを再起動する。アラートは止み、問題は「解決」したかのように見える。しかし、翌朝のチームミーティングで「なぜCPU使用率が急上昇したのか?」という根本的な問いに、あなたは明確に答えることができない。「おそらく一時的な負荷増大でしょう」という曖昧な推測でその場をしのぐ。この経験、身に覚えがありませんか?

これは、多くの開発チームが日常的に経験する「監視(モニタリング)」の限界を示す典型的なシナリオです。私たちは、事前に定義した閾値(CPU使用率、メモリ使用量、エラーレートなど)を超えるという「既知の未知(Known Unknowns)」を監視することには長けています。しかし、現代の複雑なマイクロサービスアーキテクチャやクラウドネイティブ環境では、問題の原因はもはや単一のメトリクスからは見えません。ユーザーAの特定のアクションが、サービスBのキャッシュミスを引き起こし、それがサービスCのデータベース接続を枯渇させ、結果としてサービスDのCPU使用率が急上昇する…といった、予測不可能な連鎖反応が頻繁に起こります。これらは「未知の未知(Unknown Unknowns)」、つまり、何が問題なのかすらわからない問題です。

この記事では、長年フルスタック開発者としてインフラからフロントエンドまで触れてきた私の経験に基づき、伝統的な「監視」と、現代の複雑なシステムを理解するための新しいパラダイム「オブザーバビリティ(Observability, 可観測性)」の本質的な違いを徹底的に掘り下げます。単なる用語の定義に留まらず、なぜこの違いがあなたのチームの生産性、システムの信頼性、そして最終的にはビジネスの成功にまで直結するのかを、具体的なツールやシナリオを交えて解説していきます。アラート対応に追われる日々から脱却し、システム内部で何が起きているかを自在に問いかけ、真の原因究明へと至るための航海図を、共に描いていきましょう。

監視とオブザーバビリティ:根本的な思想の違い

「監視」と「オブザーバビリティ」。多くの現場でこれらの言葉は混同されて使われがちですが、両者の間には目的、アプローチ、そしてシステムに対して投げかける「問い」の性質において、根本的な違いが存在します。この違いを理解することが、複雑化したシステムと向き合うための第一歩です。

監視(Monitoring)とは何か? 「システムは動いていますか?」

監視とは、事前に定義された質問に答えるための活動です。私たちはシステムの健全性を測るであろう指標(Key Performance Indicator, KPI)をあらかじめ選び出し、それらをダッシュボードに並べ、閾値を設定してアラートを飛ばします。

- CPU使用率は80%未満か?

- ディスクの空き容量は20%以上あるか?

- HTTP 5xxエラーの割合は1%未満か?

- レスポンスタイムの95パーセンタイル値は500ms以下か?

これらの質問は、システムが「正常」か「異常」かを判断するためのものです。監視は、私たちが過去の経験から学んだ「こうなったら危ない」というパターン(既知の未知)を検知するのに非常に有効です。車のダッシュボードにあるエンジン温度計や燃料計を思い浮かべると分かりやすいでしょう。温度が高すぎたり、燃料が少なすぎたりすると警告灯が点灯します。これは非常に重要な機能ですが、なぜエンジン温度が異常に高いのか、その根本原因(例:冷却水漏れ、サーモスタットの故障、ラジエーターファンの不具合)までは教えてくれません。

伝統的な監視は、システムをブラックボックスとして扱い、その外部から観測できる症状(Symptom)に焦点を当てます。問題が発生した際、監視は「何かがおかしい」という事実を知らせてくれますが、「なぜおかしいのか」を突き止めるための情報は限定的です。調査は、そこからエンジニアの経験と勘に頼った手作業のデバッグプロセスへと移行します。

オブザーバビリティ(Observability)とは何か? 「システムはなぜこのように動いているのですか?」

一方、オブザーバビリティは、制御理論から生まれた概念で、「システムの外部出力から、どれだけその内部状態を推測できるか」という度合いを指します。ソフトウェア開発の文脈では、システムの状態について、事前に定義されていない任意の質問を投げかけ、答えを得られる能力を意味します。

監視が「システムは動いていますか?」と問うのに対し、オブザーバビリティは「システムはなぜこのように動いているのですか?」と問います。これは、未知の未知、つまり今まで誰も予測しなかったような問題が発生したときに真価を発揮します。

例えば、以下のような複雑な問いに答える能力がオブザーバビリティです。

- 過去30分間で、特定の大口顧客(tenant_id: "xyz-123")からのAPIリクエストだけが遅延しているのはなぜか?

- カナリアリリースした新バージョンの決済サービス(v1.2.1)は、旧バージョン(v1.2.0)と比較して、データベースへのクエリ数がどれくらい増減したか?

- ある特定のエラー(`OutOfMemoryError`)が発生したリクエストは、上流のどのサービスから始まり、どのような経路を辿り、各サービスでどれくらいの時間を費やしたか?

- 商品検索機能で、特定のキーワード(例:「オブザーバビリティ」)を含むクエリだけが、なぜか他のクエリより平均50ms遅い理由は何か?

これらの質問は、単一のCPU使用率やエラーレートのグラフを眺めているだけでは決して答えられません。システムの内部から発せられる、リッチで高次元(ハイカーディナリティ)なデータを収集し、それらを縦横無尽に探索・分析できる基盤があって初めて可能になります。オブザーバビリティは、システムをガラス張りの箱(ホワイトボックス)として扱い、内部の動作原理を深く理解することを目指すアプローチなのです。

核心的な違いをテーブルで比較

両者の違いをより明確にするために、以下のテーブルにまとめました。

| 観点 | 監視(Monitoring) | オブザーバビリティ(Observability) |

|---|---|---|

| 主な目的 | システムの健全性を維持し、既知の問題を検知する | システムの内部状態を理解し、未知の問題をデバッグ・調査する |

| 答える質問 | 「はい/いいえ」で答えられる、事前に定義された質問 (例: CPU使用率は80%を超えたか?) | システムの状態に関する、任意の探索的な質問 (例: なぜこのユーザーのリクエストだけが遅いのか?) |

| 扱う問題領域 | 既知の未知 (Known Unknowns) - 予測できる問題 | 未知の未知 (Unknown Unknowns) - 予測できない、初めて遭遇する問題 |

| アプローチ | リアクティブ(問題発生後にアラートで知る) | プロアクティブ&インタラクティブ(能動的に問いかけ、システムを探索する) |

| データ収集 | 集約済みの数値データ(メトリクス)が中心。カーディナリティは低い傾向。 | 生のイベントデータ(構造化ログ、トレース)。高カーディナリティのメタデータが豊富。 |

| 主要なツール例 | Nagios, Zabbix, Prometheus (基本的な使い方) | Jaeger, Loki, OpenTelemetry, Honeycomb, Lightstep |

| 主な成果物 | ダッシュボード、アラート | デバッグのコンテキスト、インサイト、根本原因分析 |

| 思考様式 | 「もしXが起きたら、Yをせよ」という命令的な思考 | 「何が起きているのだろう?」「なぜ?」という探求的な思考 |

| 適した環境 | 比較的安定したモノリシックなシステム | 動的で複雑な分散システム(マイクロサービス、サーバーレス) |

この比較から分かるように、オブザーバビリティは監視を置き換えるものではなく、それを包含し、さらに発展させた概念です。健全なシステム運用には、基本的な監視によるアラート体制と、問題発生時に深く掘り下げるためのオブザーバビリティの両方が不可欠です。監視が「煙探知機」だとすれば、オブザーバビリティは「赤外線カメラと各種センサーを備えた調査ドローン」のようなものと言えるでしょう。

オブザーバビリティの3つの柱:メトリクス、ログ、トレース

オブザーバビリティを実現するためには、システムの内部状態を外部から理解するための「テレメトリーデータ」が不可欠です。その中でも特に重要なのが、「メトリクス」「ログ」「トレース」の3種類であり、これらは「オブザーバビリティの3つの柱」と呼ばれています。これら3つはそれぞれ異なる役割を持ち、互いに補完し合うことで、システム全体の姿を立体的に描き出します。

1. メトリクス (Metrics): システムの「健康診断」

メトリクスは、一定間隔で収集される数値データであり、システムのパフォーマンスや振る舞いの概要を把握するためのものです。人間で言えば、定期的に測定する体温、心拍数、血圧のような「バイタルサイン」に相当します。メトリクスは集約可能(合計、平均、パーセンタイルなど)で、ストレージ効率が良く、長期的な傾向分析や異常検知に適しています。

監視におけるメトリクス

伝統的な監視では、主に以下のようなシステムレベルのメトリクスが利用されます。

- CPU使用率: サーバーの計算リソースがどれだけ使われているか。

- メモリ使用量: 物理メモリの消費量。

- ディスクI/O: ディスクの読み書き速度や頻度。

- ネットワーク帯域: ネットワークインターフェースを通過するデータ量。

これらのメトリクスは、インフラの健全性を測る上で依然として重要です。しかし、これだけではアプリケーション内部で何が起きているかは全く分かりません。

オブザーバビリティにおけるメトリクス

オブザーバビリティの世界では、メトリクスはよりリッチで、ビジネスやアプリケーションの文脈を深く反映したものになります。ここで重要になるのが「カーディナリティ(Cardinality)」という概念です。

カーディナリティとは、メトリクスに付与されるラベル(ディメンション)の組み合わせの数です。例えば、http_requests_totalというメトリクスにmethod="GET",path="/api/users",status_code="200"といったラベルを付与することで、データを様々な角度からスライスして分析できます。

高カーディナリティのメトリクスを活用することで、以下のような詳細な分析が可能になります。

- ビジネスメトリクス:

user_signups_total{plan="premium", country="JP"}(プレミアムプランでの日本人ユーザーの新規登録数) - アプリケーションメトリクス:

database_query_duration_seconds{query="select_user", table="users", success="true"}(usersテーブルへのselect_userクエリの成功時の実行時間) - リクエストレベルメトリクス:

http_requests_total{customer_id="12345", endpoint="/api/v2/orders"}(特定の顧客からの注文APIへのリクエスト数)

このようなメトリクスを収集・分析する代表的なツールが Prometheus です。Prometheusは時系列データベース(TSDB)と強力なクエリ言語 PromQL を提供します。例えば、「過去5分間でHTTP 500エラーが急増しているAPIエンドポイントを特定する」といった調査は、以下のようなPromQLで実行できます。

topk(10, sum by (path) (rate(http_requests_total{status_code=~"5..", job="my-api-service"}[5m])))

メトリクスは「何かがおかしい」という兆候を素早く捉えるのに最適ですが、「なぜ」を説明するには情報が不足しています。CPU使用率が高いことは分かっても、どのリクエストが、どのコードパスがそれを引き起こしているかまでは分かりません。その「なぜ」を解明するために、次にログが必要になります。

2. ログ (Logs): イベントの「航海日誌」

ログは、システム内で発生した個別のイベントを記録した、タイムスタンプ付きのテキストデータです。アプリケーションの起動、ユーザーのリクエスト受信、エラーの発生、重要な処理の完了など、あらゆる離散的な出来事がログの対象となります。メトリクスが集約された「量」の情報であるのに対し、ログは個々のイベントに関する詳細な「質」の情報を提供します。

伝統的なログ(非構造化ログ)

昔ながらのログは、人間が読むことを前提とした自由形式のテキストでした。

INFO [2025-11-16 02:15:30,123] - User 123 requested resource /items/abc.

ERROR [2025-11-16 02:15:30,456] - Failed to connect to database: timeout expired. Request ID: xyz-789.

この形式は一見して分かりやすいですが、機械的な処理や分析には不向きです。「ユーザーIDが123のログだけを抽出する」「エラーメッセージに"timeout"を含むログを数える」といった操作は、複雑な正規表現を駆使する必要があり、処理速度も遅く、間違いやすいものでした。

オブザーバビリティのためのログ(構造化ログ)

オブザーバビリティを追求する上で、ログは構造化されていることが絶対条件となります。構造化ログは、キーと値のペアを持つ形式(JSONが最も一般的)でイベントを記録します。これにより、各イベントのコンテキストが明確になり、機械による高速な検索、フィルタリング、集計が可能になります。

{

"timestamp": "2025-11-16T02:15:30.123Z",

"level": "INFO",

"message": "User requested resource",

"app": "item-service",

"version": "1.5.2",

"user_id": 123,

"resource_id": "abc",

"http_method": "GET",

"http_path": "/items/abc"

}

{

"timestamp": "2025-11-16T02:15:30.456Z",

"level": "ERROR",

"message": "Failed to connect to database",

"app": "item-service",

"version": "1.5.2",

"error_details": "timeout expired",

"request_id": "xyz-789",

"db_host": "db.prod.internal"

}

この形式であれば、「level="ERROR" かつ app="item-service" のログを検索する」「user_id ごとにログ件数を集計する」といった分析が極めて容易になります。Grafana Loki や Elasticsearch (ELK Stack) のようなモダンなログ集約ツールは、この構造化ログを前提に設計されています。

ログは、メトリクスで検知した異常の根本原因を探るための、最も詳細な情報源です。特定のリクエストIDやユーザーIDを手がかりにログを検索することで、その瞬間にアプリケーション内部で何が起こっていたのか、どのようなコードパスを通り、どのような変数が使われていたのかを詳細に追跡できます。これは、デバッグにおいて非常に強力な武器となります。

3. トレース (Traces): リクエストの「旅路」を追う

メトリクスとログが単一のコンポーネント内での振る舞いを捉えるのに対し、トレースは分散システム全体を横断するリクエストのライフサイクルを可視化します。特に、複数のマイクロサービスが連携して1つのリクエストを処理するような現代的なアーキテクチャにおいて、トレースは不可欠です。

分散トレーシングの仕組み

分散トレーシングは、主に以下の要素で構成されます。

- トレース (Trace): システムを通過する1つのリクエスト(またはワークフロー)全体を表す。一意のTrace IDで識別される。

- スパン (Span): トレース内の個々の作業単位。例えば、「APIゲートウェイでのリクエスト受信」「認証サービスでのトークン検証」「商品サービスでのDBクエリ」などがそれぞれ1つのスパンになる。各スパンは開始時刻、終了時刻(所要時間)、および親子関係を持つ。

- コンテキスト伝播 (Context Propagation): Trace IDやSpan IDといった情報を、サービス間のリクエスト(例: HTTPヘッダー)に含めて受け渡す仕組み。これにより、バラバラのサービスで記録されたスパンを1つのトレースとして連結できる。

この仕組みにより、ユーザーからの1つのクリックが、システム内部でどのように処理されていくかを、以下のようなガントチャート形式で可視化できます。

- リクエスト全体の所要時間はどれくらいか?

- どのサービス、どの処理がボトルネックになっているか?

- リクエストの途中でエラーが発生した場合、それはどのサービスで起きたか?

- サービス間の呼び出し関係(依存関係)はどうなっているか?

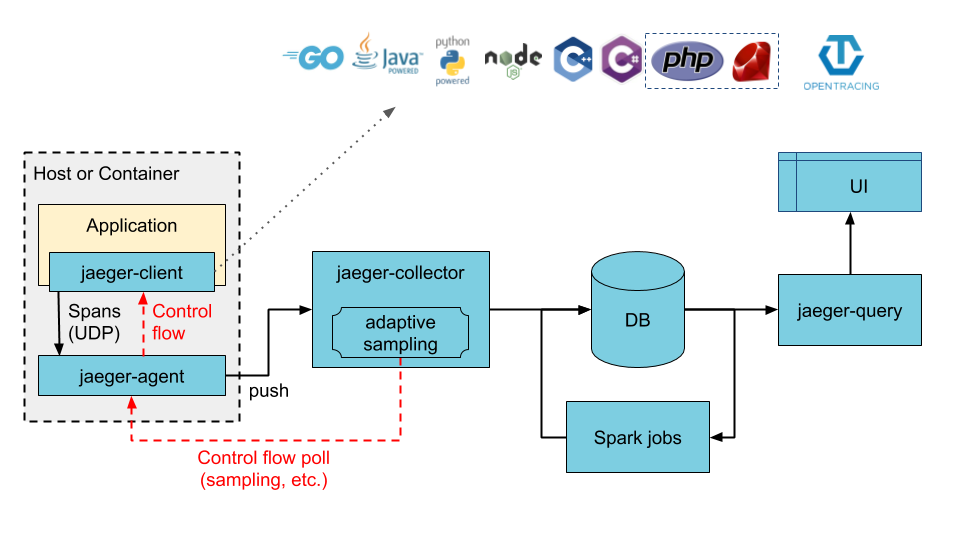

トレースは、パフォーマンス問題の特定や、サービス間連携の複雑な問題を解決する上で絶大な効果を発揮します。Jaeger や Zipkin といったツールが有名ですが、近年では OpenTelemetry という標準化された仕様に集約されつつあります。

3つの柱の連携

オブザーバビリティの真価は、これら3つの柱が連携したときに発揮されます。

- [メトリクス] ダッシュボードのアラート(例: 決済APIの99パーセンタイルレイテンシーが5秒を超過)で問題を検知する。

- [トレース] その時間帯に発生した遅いリクエストのトレースを調べる。すると、特定のマイクロサービス(在庫確認サービス)の処理に4.5秒かかっていることが判明する。

- [ログ] そのトレースID(またはリクエストID)をキーに、在庫確認サービスのログを検索する。すると、「外部倉庫APIへの接続でリトライが3回発生」というエラーログが見つかる。

このように、メトリクスで「何が (What)」問題かを知り、トレースで「どこで (Where)」問題が起きているかを特定し、ログで「なぜ (Why)」そうなったのかという根本原因を突き止める。このシームレスな連携こそが、オブザーバビリティが目指すデバッグ体験なのです。

なぜ今、オブザーバビリティが重要なのか? マイクロサービスの台頭

オブザーバビリティという概念自体は新しいものではありませんが、ここ数年で急速に注目を集めるようになった背景には、ソフトウェアアーキテクチャの劇的な変化があります。具体的には、モノリシックアーキテクチャからマイクロサービスアーキテクチャへの移行です。

モノリス時代の監視

かつてのモノリシックなアプリケーションでは、すべての機能が単一のプロセス、単一のコードベースに詰め込まれていました。問題が発生した場合、調査対象はそのサーバーの中だけでした。

- サーバーにSSHでログインし、

topやhtopでCPUを消費しているプロセスを特定する。 - アプリケーションログファイル (

/var/log/app.log) をgrepやtailで調べる。 - デバッガをアタッチして、コードをステップ実行する。

システムは比較的シンプルで、コンポーネント間の連携はプロセス内の関数呼び出しに過ぎませんでした。そのため、CPU、メモリ、ディスクといった基本的なメトリクスを監視し、ログファイルを丹念に読めば、多くの問題は解決可能でした。システムの振る舞いは予測しやすく、「既知の未知」に対応する伝統的な監視がうまく機能していたのです。

マイクロサービス時代の複雑性

しかし、マイクロサービスアーキテクチャの普及により、状況は一変しました。単一の巨大なアプリケーションは、それぞれが独立してデプロイ・スケール可能な、数十から数百の小さなサービス群に分割されました。

このアーキテクチャは、開発の俊敏性やスケーラビリティといった多くの利点をもたらしましたが、同時にシステム全体の複雑性を爆発的に増大させました。

- 分散した障害点: ユーザーからの1つのリクエストが、ネットワーク越しに5つも10つものサービスを呼び出すのが当たり前になりました。問題はシステムのどこででも起こりえます。ネットワークの遅延、サービス間の認証エラー、片方のサービスのデプロイによる互換性の問題など、考慮すべき障害点が指数関数的に増加しました。

- 非同期通信とカスケード障害: メッセージキューなどを介した非同期通信が多用されることで、問題の発生源と症状が現れる場所が時間的・空間的に離れるようになりました。また、ある1つのサービスの小さな遅延が、雪崩のように下流のサービス全体に影響を及ぼす「カスケード障害」のリスクも高まりました。

- 動的な環境: コンテナ技術(Docker)とオーケストレーションツール(Kubernetes)の登場により、インフラは非常に動的になりました。サーバーはもはやペットのように大切に管理されるものではなく、家畜のように数秒で生まれ、死んでいきます。IPアドレスやホスト名といった従来の識別子は意味をなさなくなり、障害調査中に問題のコンテナが消滅していることも珍しくありません。

このような環境では、個々のサービスのCPU使用率を監視しているだけでは、もはやシステム全体で何が起きているのか全く理解できません。「ユーザーの決済が失敗した」という問題に対し、認証サービス、商品サービス、在庫サービス、決済代行ゲートウェイ、通知サービス…と、関係する全てのサービスのログとメトリクスを手作業で横断的に調べるのは、干し草の山から針を探すようなものです。

ここでオブザーバビリティが必要になります。サービスを横断するリクエストの全体像を可視化する「分散トレーシング」や、全てのログやメトリクスにリクエストIDや顧客IDといった共通のコンテキストを付与して一元的に分析できる仕組みがなければ、複雑な分散システムの問題解決は不可能です。マイクロサービスの複雑性こそが、私たちが監視からオブザーバビリティへとパラダイムシフトを迫られている最大の理由なのです。

SREとオブザーバビリティ:切っても切れない関係

オブザーバビリティの重要性を語る上で、SRE (Site Reliability Engineering) のプラクティスを抜きにしては語れません。Googleによって提唱されたSREは、ソフトウェアエンジニアリングの原則をインフラと運用業務に適用するアプローチであり、オブザーバビリティはその活動を支える根幹技術です。

SLO、SLI、そしてエラーバジェット

SREの中心的な概念に、SLI、SLO、エラーバジェットがあります。

- SLI (Service Level Indicator): サービスのパフォーマンスを測る定量的な指標。例えば、「HTTPリクエストの成功率」や「レスポンスタイムの99パーセンタイル値」など。これはオブザーバビリティにおけるメトリクスそのものです。

- SLO (Service Level Objective): SLIが達成すべき目標値。例えば、「月間のリクエスト成功率を99.9%以上にする」といった具体的な目標。

- エラーバジェット (Error Budget): 許容されるエラーの量。SLOが99.9%であれば、残りの0.1%がエラーバジェットになります。このバジェットの範囲内であれば、チームは新機能のリリースなど、リスクを伴う変更を積極的に行うことができます。バジェットを使い切ってしまうと、機能開発を凍結し、信頼性向上に注力する必要があります。

この仕組みを効果的に運用するには、正確で信頼性の高いSLI、つまり質の高いメトリクスが不可欠です。しかし、それだけでは十分ではありません。

オブザーバビリティがSREをどう強化するか

SREチームの役割は、単にSLOを監視することではありません。SLOが脅かされたときになぜそうなったのかを迅速に解明し、エラーバジェットの消費を抑え、将来のインシデントを防ぐための改善策を講じることです。ここでオブザーバビリティが決定的な役割を果たします。

インシデント対応の高速化: エラーバジェットが急速に消費されているアラートが発生したとします。伝統的な監視環境では、原因究明に数時間から数日かかることもありました。しかし、オブザーバビリティが確保された環境では、SREはメトリクス、トレース、ログを横断的に分析し、数分で根本原因(例:「特定の顧客テナントからの不正な形式のリクエストが、サービスXのパーサーをクラッシュさせている」)を特定できます。これにより、MTTR (Mean Time To Repair, 平均修復時間) が劇的に短縮され、エラーバジェットの消費を最小限に食い止められます。

ポストモーテムの質の向上: インシデント解決後、SREは再発防止策を検討するためにポストモーテム(事後検証)を実施します。オブザーバビリティによって収集された詳細なデータ(問題のリクエストのトレース、関連する全サービスのログ、その時の各コンポーネントのメトリクスなど)があれば、憶測ではなく事実に基づいた深い分析が可能になります。「なぜこの問題は検知できなかったのか?」「どのSLIを追加すれば、この種の問題を早期に発見できるか?」といった、より本質的な改善に繋がる議論ができます。

信頼性と機能開発のバランス: オブザーバビリティは、エラーバジェットを消費している原因を特定するだけでなく、「どのような変更が信頼性にどう影響したか」を明確に示します。例えば、新機能Aのリリース後、特定のエンドポイントのレイテンシSLIが悪化し始めたことをデータで示せれば、開発チームはパフォーマンス改善のための具体的なアクションを取ることができます。このように、オブザーバビリティは、開発の速度とシステムの信頼性という、しばしばトレードオフになる2つの要素について、データに基づいた客観的な対話を促進する共通言語として機能します。

要するに、SREが「何を」達成すべきか(SLO)を定義するフレームワークであるとすれば、オブザーバビリティは「どのようにして」それを達成し、問題発生時に「なぜ」を解明するための具体的な技術的基盤です。両者は車の両輪であり、モダンなシステム運用において、一方を欠いて他方を実践することは極めて困難です。

オブザーバビリティ実現への道:OpenTelemetryという標準

オブザーバビリティの重要性を理解したところで、次なる疑問は「どうすれば実現できるのか?」でしょう。これまで、テレメトリーデータを収集するためのライブラリやエージェントは、各監視ツールベンダー(Datadog, New Relicなど)が独自に提供しており、開発者は特定のベンダーの仕様にロックインされるという課題がありました。

この状況を打開するために登場したのが、OpenTelemetry (OTel) です。

OpenTelemetryとは何か?

OpenTelemetryは、Cloud Native Computing Foundation (CNCF) のプロジェクトであり、トレース、メトリクス、ログといったテレメトリーデータの生成、収集、エクスポートに関する仕様、API、SDK、ツールを標準化することを目的としています。これは、かつてログの世界でSLF4J(Simple Logging Facade for Java)が果たした役割を、オブザーバビリティ全体に対して行うものと考えることができます。

OpenTelemetryの最大の利点は、計装(Instrumentation)とバックエンドの分離です。

- 開発者は、アプリケーションのコードにOpenTelemetryのAPI/SDKを使って一度だけ計装を施します。(計装とは、テレメトリーデータを生成するコードを埋め込むことです)

- そして、アプリケーションの設定を変更するだけで、収集したデータをJaeger, Prometheus, Loki, あるいは任意の商用SaaSなど、様々なバックエンドに送信先を切り替えることができます。

これにより、ベンダーロックインを回避し、将来的に分析ツールを変更する際の自由度を確保できます。また、多くの言語やフレームワーク(Java, Go, Python, Node.js, Ruby, .NETなど)に対して、HTTPリクエストやDBクエリといった一般的な操作を自動で計装してくれるライブラリが提供されており、導入のハードルを大幅に下げています。

簡単な計装の例 (Node.js/Express)

実際にOpenTelemetryを使って、簡単なNode.jsのWebアプリケーションを計装してみましょう。ここでは、コンソールにトレース情報を出力するだけのシンプルな設定を行います。

まず、必要なパッケージをインストールします。

npm init -y

npm install express

npm install @opentelemetry/sdk-node @opentelemetry/auto-instrumentations-node @opentelemetry/api

次に、OpenTelemetryの初期化を行うtracing.jsというファイルを作成します。

// tracing.js

const { NodeSDK } = require('@opentelemetry/sdk-node');

const { ConsoleSpanExporter } = require('@opentelemetry/sdk-trace-node');

const { getNodeAutoInstrumentations } = require('@opentelemetry/auto-instrumentations-node');

const {

PeriodicExportingMetricReader,

ConsoleMetricExporter,

} = require('@opentelemetry/sdk-metrics');

// OpenTelemetry SDKを初期化

const sdk = new NodeSDK({

// トレース情報のエクスポーターとして、コンソール出力を指定

traceExporter: new ConsoleSpanExporter(),

// メトリクス情報のエクスポーターとして、コンソール出力を指定

metricReader: new PeriodicExportingMetricReader({

exporter: new ConsoleMetricExporter(),

}),

// 一般的なライブラリ(http, expressなど)を自動で計装する

instrumentations: [getNodeAutoInstrumentations()],

});

// SDKを開始

sdk.start();

// アプリケーション終了時にSDKをシャットダウンする処理

process.on('SIGTERM', () => {

sdk.shutdown()

.then(() => console.log('Tracing terminated'))

.catch((error) => console.log('Error terminating tracing', error))

.finally(() => process.exit(0));

});

そして、アプリケーション本体のapp.jsです。

// app.js

const express = require('express');

const api = require('@opentelemetry/api');

const app = express();

const PORT = 3000;

app.get('/hello', (req, res) => {

// 現在アクティブなスパンを取得し、カスタム属性を追加

const span = api.trace.getActiveSpan();

if (span) {

span.setAttribute('user.agent', req.headers['user-agent']);

span.addEvent('Processing hello request');

}

res.send('Hello, Observability!');

});

app.listen(PORT, () => {

console.log(`Server is running on http://localhost:${PORT}`);

});

このアプリケーションを、tracing.jsを読み込む形で起動します。

node --require ./tracing.js app.js

curl http://localhost:3000/hello を実行すると、サーバーのコンソールに以下のようなJSON形式のスパン情報が出力されます。これがトレースデータです。

{

"traceId": "a1b2c3d4e5f6...",

"parentId": undefined,

"name": "GET /hello",

"id": "f1e2d3c4b5a6...",

"kind": 1,

"timestamp": 1678886400000000,

"duration": 5123, // in microseconds

"attributes": {

"http.method": "GET",

"http.target": "/hello",

"http.status_code": 200,

"user.agent": "curl/7.81.0"

},

"status": { "code": 1 },

"events": [

{ "name": "Processing hello request", "timestamp": 1678886400002000 }

]

}

この例ではコンソールに出力しているだけですが、tracing.jsのtraceExporterをJaegerExporterやPrometheusExporterに変更するだけで、実際の分析バックエンドにデータを送信できます。アプリケーションコード(app.js)には一切変更を加える必要がない、という点がOpenTelemetryの強力さです。

オブザーバビリティの実現は、ツールの導入だけで完結するものではありません。開発者全員が計装の重要性を理解し、意味のある属性やイベントをスパンに追加したり、構造化ログに適切なコンテキストを含めたりする文化を醸成することが不可欠です。しかし、OpenTelemetryという共通の基盤は、その文化を育むための技術的な障壁を劇的に下げてくれる、強力な第一歩となるでしょう。

結論:監視の先へ、システムとの新たな対話法

この記事では、伝統的な「監視」と現代的な「オブザーバビリティ」の間の、深く、そして本質的な違いを掘り下げてきました。

監視は、私たちが既知のリスクに対して設置する「警報システム」です。事前に定義したダッシュボードとアラートを通じて、「システムは正常か?」という問いに答えてくれます。これは今もなお、安定したシステム運用の基盤として不可欠です。

しかし、マイクロサービス、コンテナ、クラウドといった技術が織りなす現代の分散システムは、予測不可能な「未知の未知」の問題に満ちています。このような複雑な世界で、私たちは新たな問いを立てる必要があります。「このシステムは、なぜ今、このように振る舞っているのか?」

この問いに答える能力こそが、オブザーバビリティです。それは単なるツールの集合体ではなく、システムを内部から理解し、能動的に問いを投げかけ、デバッグするための新しいアプローチ、一種の文化です。その実践は、連携し合う3つの柱によって支えられています。

- メトリクスが異常の「兆候」を知らせ、

- トレースが問題の「場所」を特定し、

- ログが根本的な「理由」を明らかにする。

フルスタック開発者として私たちが目指すべきは、アラートに追われるだけの「消防士」でいることではありません。システムの内部構造を深く理解し、データに基づいて仮説を立て、それを検証していく「科学者」あるいは「探偵」のような存在になることです。オブザーバビリティは、そのための最も強力な思考のフレームワークと実践的なツールキットを提供してくれます。

OpenTelemetryのような標準技術の登場により、オブザーバビリティ実現への道はかつてないほど開かれています。あなたのチームが次に不可解な本番障害に遭遇したとき、「なぜこれが起きたのか、誰にも分からない」と嘆くのではなく、「よし、データに聞いてみよう」と言えるかどうか。その分水嶺に、監視とオブザーバビリティの違いが横たわっているのです。その一歩を踏み出すことで、私たちはシステムとの対話の方法を根本的に変え、より回復力のある、より理解しやすいソフトウェアを構築していくことができるでしょう。

Post a Comment